[论文笔记]Admix: Enhancing the Transferability of Adversarial Attacks

Admix: Enhancing the Transferability of Adversarial Attacks

前言

ICCV 2021 原文链接:Admix: Enhancing the Transferability of Adversarial Attacks (thecvf.com)

论文源码:https://github.com/JHL-HUST/Admix

本文作于2022年4月20日

1.解决的问题

人们提出了各种方法来提高对抗样本的迁移性,其中输入多样性是最有效的方法之一。我们朝着这个方向进行研究,发现现有的转换都应用于单个图像,这可能会限制对抗性的迁移性。为此,我们提出了一种新的基于输入变换的攻击方法,称为混合攻击(Admix),该方法考虑了输入图像和从其他类别随机采样的一组图像。与直接计算原始输入上的梯度不同,“Admix”计算原始图像混合一小部分附加图像的梯度,同时使用输入的原始标签来制造更多可迁移的样本。本文为进一步提高迁移性,可以与现有的输入转换相结合。

2.提出的方法

2.1 背景

现有的输入转化方法:

- TIM:通过使用预定义的内核对未平移图像的梯度进行卷积来实

- DIM:在每次迭代计算梯度之前,都进行一次概率为P的图像变换。(包括图像缩放和图像填充)

- SIM:发现DNN的缩放不变性,并计算更新的输入的缩放图像的平均梯度。

NI-FGSM里面将对抗样本的生成过程类比于神经模型训练过程,生成对抗样本的迁移性可等效于训练模型的泛化性,在这种观点下,输入转换可以被视为数据增广

思路:借鉴Mixup(将两个图像同等对待并相应地混合其标签)提高模型泛化性的思想,ICLR2018年提出的一种数据增强方法,一种简单且数据无关的数据增强方式。

直接将这个手段应用于生成对抗样本,略微提高了迁移性,但是在白盒攻击下降低了性能,主要有两个原因:

- x与x′ 没有区别,在x梯度计算时,使用了太多附加图像x′ 的信息,因此提供了不正确更新方向

- 当x与x′不是同一类时,混合标签,引入其他类别的梯度进行更新

2.2 方法

混合样本

为了在不影响白盒攻击性能的前提下利用其他类别图像的信息,提出了将两种图像以主从方式混合的混合操作方法。具体来说,我们将原始图像 x 作为主图像,并将其与从其他类别中随机选取的副图像x′ 混合:

其中 \eta=\eta^{`}/\gamma , \gamma\in[0,1] , \eta^{`}\in[0,\gamma) ,控制了原始图像和随机采样图像的比例,通过这种方式,我们可以确保图像x′ 总是占据很小的比例,限定住了主从关系,对于 \tilde{x} 使用原始图像x的标签

计算混合图像的平均梯度

其中 m_{1} 是x′ 图像的数量, m_{2} 随机采样图像,X′ 定义为一些列m_{2} 的种类(原文描述没怎么理解,根据后续的消融研究,可以知道,m_{1}是和SIM的m一个意思,m_{2}代表的是随机采样图像的数量)

完整算法:

2.3 Admix与Mixup的差异

- Mixup的目标是提高经过训练的DNN的泛化能力,而Admix的目标是生成更多可迁移的对抗样本。

- Mixup对x和x′一视同仁,还混搭了x和x′的标签。相比之下,Admix将x视为主要成分,并结合了一小部分x′,同时保留了x的标签。

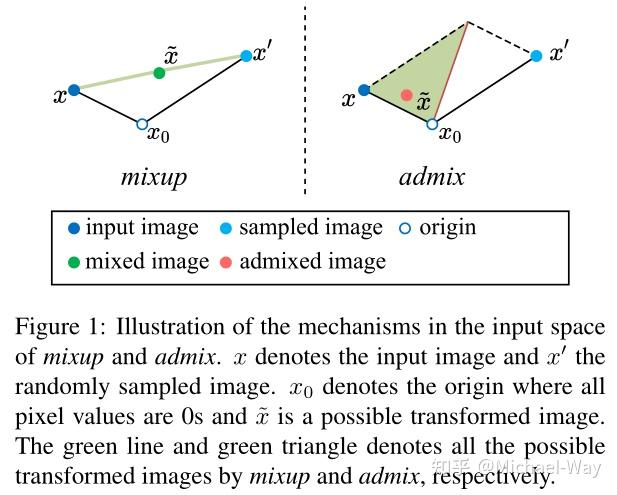

- 如图所示,Mixup线性插值x和x′,而Admix没有这样的约束,导致变换后的图像更分散。

3.实验结果

Dataset、Models、Baselines,Hyper-parameters设定参考VMI-FGSM

其中 m_{1} =5, m_{2} =3, \eta =0.2

3.1 Evaluation on Single Input Transformation

3.2 Evaluation on Combined Input Transformation

3.3 Evaluation on Ensemble-model Attack

3.4 Evaluation on Advanced Defense Models

3.5 Ablation Studies

On the number of sampled images x′.

由于 m_{2 } 的值越大表示计算成本越高,因此我们将m_{2 }设置为3以平衡计算成本和攻击性能。

On the admixed strength of sampled image x′

当我们增加η时,可转移性迅速增加,当η=0.2时,Admix在对抗训练模型上达到峰值,当η=0.2或η=0.25时,对于Admix-Ti-DIM在所有模型上时达到峰值。通常,我们将η设为0.2以获得更好的性能。

4.结论

在这项工作中,我们提出了一种新的输入转换方法,称为Admix,来增强对抗样本的迁移性。具体来说,对于每个输入图像,我们从其他类别中随机采样一组图像,并将每个采样图像的一小部分混合到原始图像中,以制作一组不同的图像,但使用原始标签进行梯度计算。大量评估表明,与现有的基于输入转换的攻击相比,所提出的Admix攻击方法可以实现更好的对抗性迁移,同时在白盒设置下保持较高的攻击成功率。在我们看来,Admix是一种新的对抗性学习数据论证范式,其中混合的图像更接近决策边界,提供更多可迁移的样本。我们希望我们采用其他类别信息的Admix攻击将为对抗性攻击的潜在方向提供线索。