Este niño prodigio quiso hacer como en 'Moneyball' con las GPU y ha creado un modelo de IA de 3 millones de dólares por 30.000 dólares

Robert Wright

- La startup Daimon Labs intenta desarrollar asistentes virtuales de inteligencia artificial con una "empatía similar a la humana".

- Su CEO, Ryan Benmalek, y sus cofundadores han tenido que ser creativos para entrenar su modelo de IA sin tener acceso a tarjetas gráficas de última generación, pero han conseguido reducir el coste de entrenamiento en casi un 99%.

La carrera por construir modelos de inteligencia artificial cada vez más grandes ha desatado una fiebre del oro por la potencia de cálculo.

En Silicon Valley, las unidades de procesamiento gráfico o tarjetas gráficas —GPU, por sus siglas en inglés— se han convertido en moneda de cambio: los que las fabrican se hacen ricos, los que las tienen se convierten en reyes y los que las necesitan las compran por miles.

Empresas como OpenAI, Anthropic o Cohere tienen miles de millones de GPU en sus manos, por no mencionar el respaldo de los mayores proveedores de computación en la nube del mundo. Daimon Labs, por el contrario, había recaudado 1,5 millones de dólares de un puñado de sociedades de capital riesgo (en torno a 1,4 millones de euros), pero Benmalek estaba decidido a desarrollar su modelo.

Calculó que una sola prueba de entrenamiento les costaría alrededor de 3 millones de dólares (unos 2,7 millones de euros), pero ellos tenían que hacerlo por menos de 30.000. "No podíamos permitirnos hacer lo que hacía todo el mundo", explica el director ejecutivo de Daimon Labs, "así que, ¿cómo conseguirlo?".

"Máquinas de amor y gracia"

Como tenía pocos amigos y era alérgico a la mayoría de los animales domésticos, Benmalek dice que se pasaba el día absorto en la ciencia ficción, sobre todo en las historias de robots de Isaac Asimov. Soñaba con construir algún día su propia mascota robótica, una con superinteligencia, una que no le cerrase la tráquea.

Este niño prodigio se saltó los dos últimos años de instituto y a los 14 se matriculó en la Universidad de Washington, Estados Unidos. A los 24 años se había doctorado en visión artificial y procesamiento del lenguaje natural en Cornell y había trabajado en laboratorios de investigación avanzada de IA en Amazon, Apple y Google.

Fue entonces cuando fundó Daimon Labs, junto a Dhruv Malik y Xiang Zhang, para perseguir el sueño de lo que él llama "máquinas de amor y gracia".

Se imagina una inteligencia artificial emocional e intuitiva, con empatía humana, algo entre una mascota y un amigo, con la sensibilidad de un pez de colores y la conversación de un viejo conocido, que vivirá a tu lado desde que seas adolescente hasta el día de tu muerte.

Pero Benmalek sabía que no podía permitirse construir un chatbot con esa capacidad, a menos que fuese creativo.

FLOPS

Su primera inspiración fue Moneyball, el libro de Michael Lewis de 2003. Como se describe en ese texto, el equipo de béisbol Oakland Athletics dejó de comprar jugadores y empezó a comprar victorias. Benmalek decidió dejar de comprar GPU y empezar a comprar FLOPS.

Los FLOPS, u operaciones de coma flotante por segundo, son una medida de la rapidez con la que un modelo de IA puede resolver ecuaciones y, por tanto, del tiempo que tardará en entrenarse. No importaba cuánto se gastase Daimon en tarjetas gráficas mientras pudiese conseguir los flops que necesitaba.

En ese momento, los microchips Nvidia A100, el estándar de calidad para las GPU de nivel empresarial, se vendían a más de 30.000 euros cada uno. Pero Benmalek se dio cuenta de que podía conseguir la 4090 de Nvidia, la tarjeta gráfica de consumo de mayor calidad del fabricante, por una vigésima parte de lo que costaba el A100.

"Pensé: ¿cuál es realmente la diferencia? La respuesta es… no mucha", afirma, "la mayor diferencia es la cantidad de memoria que tiene cada GPU, que te limita en términos de lo grande que puede ser el modelo que estás entrenando".

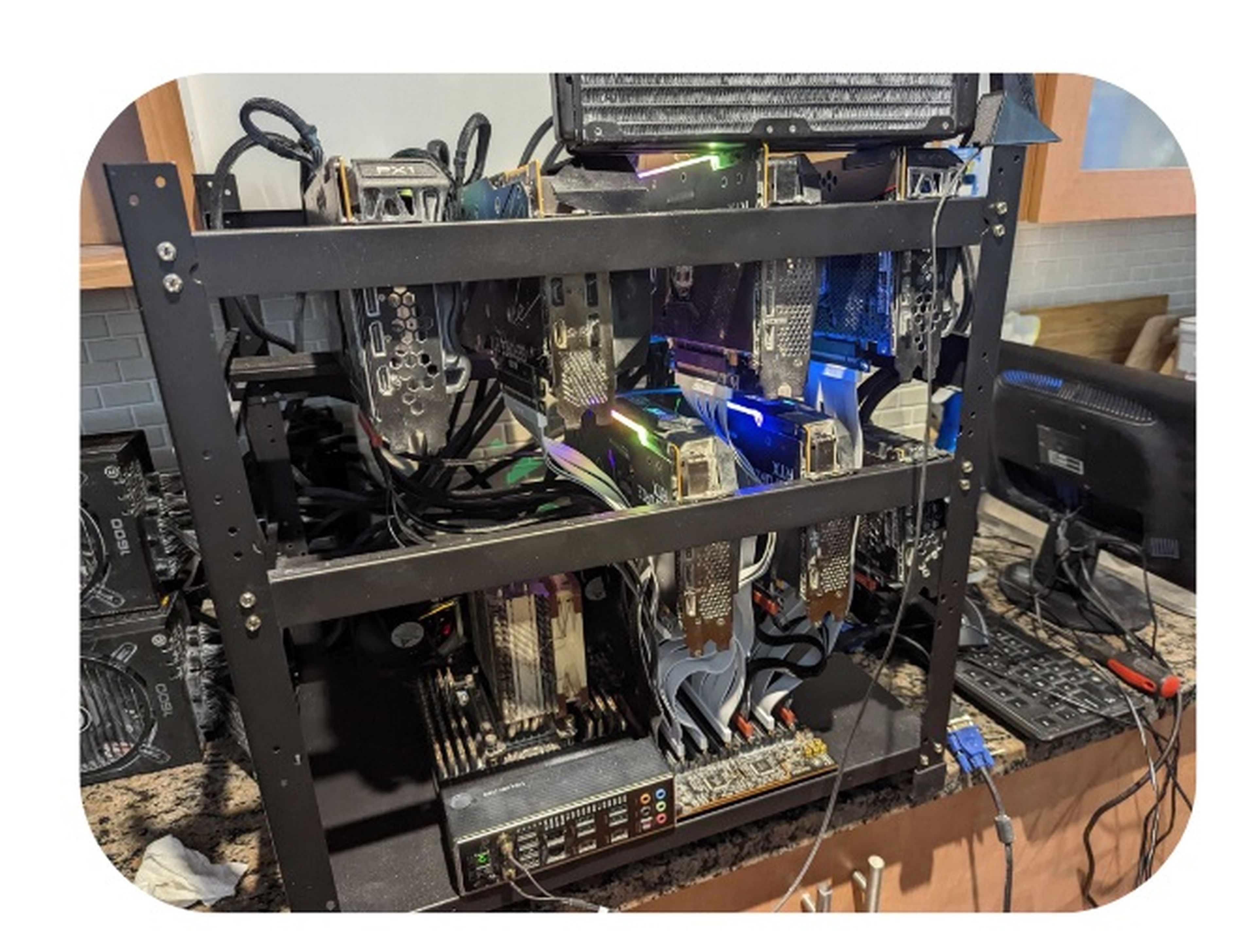

El CEO de Daimon Labs vigilaba obsesivamente las páginas web de reventa de tarjetas gráficas y se hacía con equipos de minería de bitcoins de segunda mano. Sus cofundadores y él desmontaban los chips obsoletos, los limpiaban, reescribían los kernels y construían una granja de servidores improvisada en un apartamento de Montreal, Canadá.

Cortesía de Daimon Labs

El siguiente descubrimiento de Benmalek fue que no necesitaba medir el éxito como lo hacían OpenAI o Anthropic. No le importaba lo bueno que fuese el modelo a la hora de completar tareas complejas, solo le importaba cómo le hacía sentir.

"Ellos lo entrenan para que resuelva mejor un problema matemático, nosotros lo entrenamos para que te sientas mejor cuando no puedes dormir a las 3 de la mañana", defiende este emprendedor.

Benmalek ignoró todas las métricas de éxito de un modelo de inteligencia artificial, excepto una: la perplejidad.

Es una medida del grado de certeza del modelo de IA en sus predicciones. El joven empresario sabía que, para que su robot pareciese lo bastante humano, necesitaría una perplejidad al menos tan alta como la del GPT-3 de Open AI (un modelo de 175.000 millones de parámetros), pero utilizando solo 8.000 millones de parámetros. Así que tendría que sacrificarlo todo por la perplejidad.

Incluso con un hardware despiadadamente optimizado y ese único objetivo, Daimon Labs no podía permitirse construir el modelo que Benmalek estaba imaginando.

El debut de Brooklyn

La pieza final la aportaron los científicos de DeepMind que, en 2022, publicaron un artículo de investigación que se conocería como el documento RETRO. En él se proponía un nuevo enfoque de entrenamiento que permitiría a los modelos de inteligencia artificial "recuperar" fragmentos de datos de sus conjuntos de entrenamiento y utilizarlos para complementar sus propias predicciones.

Si un método de entrenamiento tradicional es como pedirle al modelo que recuerde todo Internet, Benmalek dice que esto es como darle al modelo un libro de texto al que pueda remitirse. Se dio cuenta de que podía construir algo similar que permitiese a su modelo hacer más con mucha menos potencia de cálculo.

Utilizando una versión de este enfoque, Daimon fue capaz de reducir el coste de una prueba de entrenamiento de los 3 millones que les iba a costar en un primer momento a apenas 30.000 euros.

Y finalmente, una mañana de febrero de 2023, tras solo dos sesiones de entrenamiento, Daimon Labs logró su objetivo: su modelo de 8.000 millones de parámetros, apodado entonces Brooklyn, había alcanzado la perplejidad de GPT-3.

"¡Brooklyn! ¡Ya estás trabajando!", fue lo primero que le dijo Benmalek a su chatbot. "¡Ya! Aquí estoy, listo para charlar. ¿Qué tienes en mente hoy?", respondió Brooklyn.

Desde entonces, el chatbot de Daimon —que ahora se llama Adora— ha entrado en una fase de beta en la que han participado unos cinco mil usuarios.

Uno de ellos utiliza Adora para practicar conversaciones con su novio a distancia. Un adolescente de una zona rural de Carolina del Norte envía a Adora más de 200 mensajes al día sobre la historia que está escribiendo. Una japonesa que se trasladó a Canadá para cuidar de su madre enferma habla con Adora todas las mañanas sobre sus proyectos artísticos.

¿Es una máquina de amor y gracia totalmente consciente que se apoyará en tu hombro? No del todo. Y probablemente no acabe con OpenAI o Anthropic en un futuro próximo. Pero su existencia dice algo sobre la dificultad de lo imposible en la era de la inteligencia artificial.

Otros artículos interesantes:

Conoce cómo trabajamos en Business Insider.